ChatGPT als Lernwerkzeug: Wer trainiert hier wen?

Achtung Falle! Chatbots kompetent einsetzen

Sprachmodelle im Chatbot-Format wie etwa ChatGPT beantworten (scheinbar) all unsere Fragen. Für Lernende klingt dies verführerisch, und Schreibaufgaben erledigen sich fast von allein. Lehrende zweifeln womöglich an ihrer Existenzberechtigung, zumindest wenn es nicht um haptische Tätigkeiten geht. Dabei antworten KI-Chatbots sprachlich überzeugend, aber manchmal auch falsch. Was für die einen nach Utopie klingt, ist für die anderen Dystopie. Aktuell trifft keines der Extremszenarien zu. Klar ist aber, dass die Nutzung von Chatbots alltäglich werden wird. Die Ertüchtigung von Lehrenden und Lernenden ist daher unumgänglich.

Wer fragt, führt!

Chatbot-Nutzer*innen müssen zunächst wissen, welche Fragen sie im Eingabefeld stellen dürfen. Verzichtet werden muss auf Fragen, die aus regulatorischen Gründen (Firmenpolicy) nicht erlaubt sind sowie auf solche, die sich aus ethischen Gründen verbieten (zum Beispiel Anleitungen für kriminelle Handlungen). Auch auf Fragen, die ein Chatbot aufgrund seiner Datenbasis nicht korrekt beantworten kann, sollte verzichten, wer ein valides Ergebnis braucht. Die Eingabe von personenbezogenen Daten oder vertraulichen Informationen ist immer problematisch. Je präziser eine Frage ist, desto besser fällt die Antwort aus. Aber wie im richtigen Leben muss auch das präzise Fragenstellen geübt werden.

KI-Prozesse verstehen

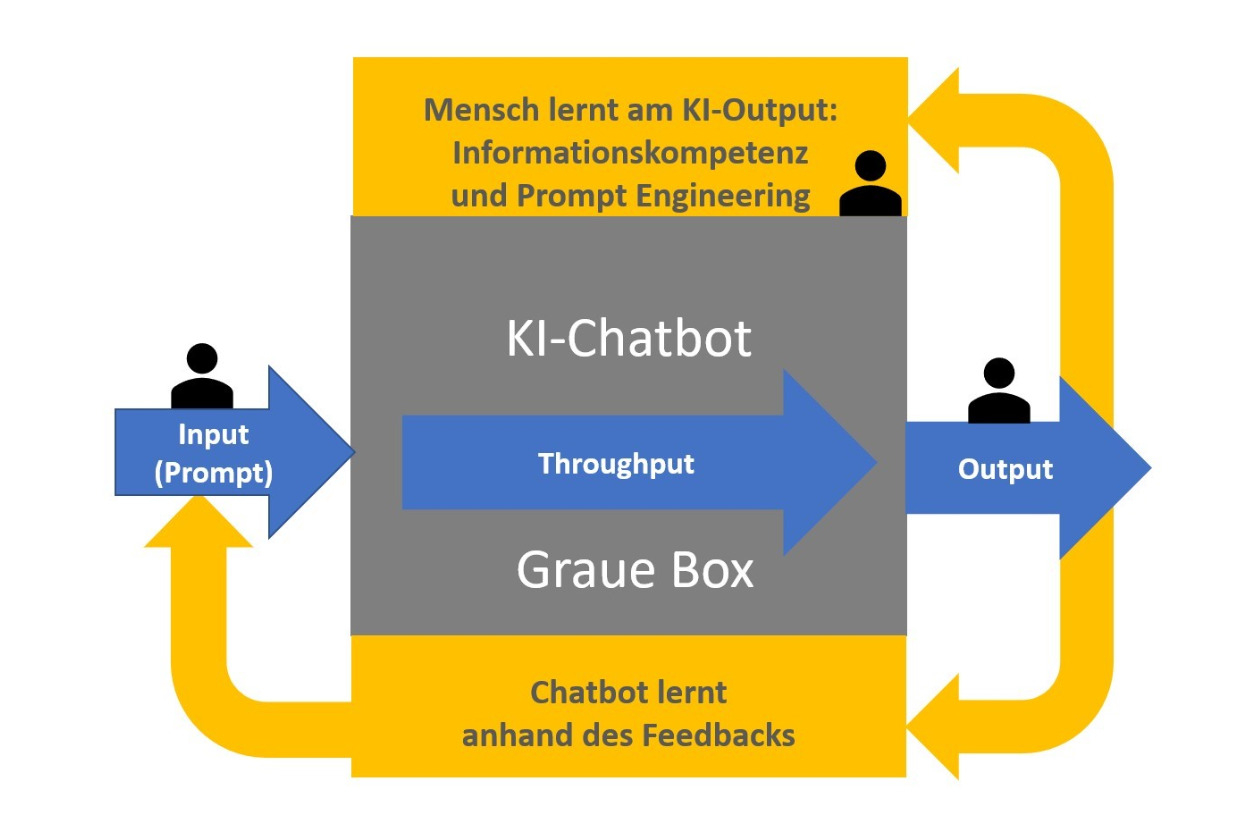

Moderne KI-basierte Chatbots sind trotz diverser Forderungen nach Transparenz eine „graue Box“. Die Algorithmen und voreingestellte Filter sind nur teilweise bekannt, und die genauen Lernprozesse in großen neuronalen Netzen entziehen sich auch der Kenntnis ihrer Urheber*innen. Wichtig ist jedoch auch für Laien, die Grundlagen von KI zu verstehen, um Fallstricke zu erkennen. Interessierte können diese Grundlagen auch ganz ohne Computer erwerben, wie eine Lernunterlage der Universität Erlangen-Nürnberg zeigt. Grundsätzlich ist klar, dass KI-Anbieter wirtschaftliche Interessen verfolgen und nicht frei von politischen Einflüssen sind. Das sollte man bei der Interpretation aller KI-Angebote und KI-Ergebnisse bedenken.

Grafik: CC BY-SA, Wolfgang König, basierend auf der Grafik "Graue-Box-Modell der Chatbox-Didaktik", http://dx.doi.org/10.13140/RG.2.2.11422.00321/1, entwickelt im BMBF-geförderten Projekt "Netzwerk Q 4.0 in MV-Schwerin".

Chatbot-Orakel deuten: eine Aufgabe für Menschen

Die Antworten von Chatbots klingen meist logisch, sind aber nicht immer korrekt und häufig (zunächst) recht unkonkret. Anwender*innen müssen deshalb über Knowhow im Themenfeld der Anfrage verfügen, damit Sie die Antworten bewerten können. Wenn diese Voraussetzung gegeben ist, dann ist erstaunlich viel möglich. So erläutert Wolfgang König von der Regionalen Koordinierungsstelle Netzwerk Q 4.0 in einem Video anschaulich im Dialog mit ChatGPT, wie die KI Ausbildner*innen bei der Umsetzung von Lernzielen nach der Bloomschen Taxonomie unterstützen kann. Der Chatbot liefert Ideen für seinen Einsatz für die Lernziel-Erreichung auf allen Stufen der Taxonomie, und zwar am Beispiel eines konkreten Fachinhalts. Im Anschluss bewertet das Programm die Qualität seiner Vorschläge und schätzt den Aufwand der nötigen Validierung durch einen Menschen.

Chatbots durch Feedback trainieren

Kompetente Anwender*innen erkennen falsche Antworten. Sie können Chatbots darauf hinweisen und sie dadurch trainieren. Darauf aufbauend können dann sinnvolle Ergebnisse entstehen. Ein Beispiel dafür zeigt ein weiteres Video von Wolfgang König, in dem ChatGPT eine Frage zwar in überzeugenden Formulierungen, aber sachlich falsch beantwortet. Nach mehrfachem Nachfragen und Korrigieren steigt die Qualität der Antworten deutlich. Das Video illustriert auch die Gefahren einer „Recherche“ mit ChatGPT – also einem Sprachmodell, das nicht für korrekte Antworten optimiert ist. Mit Stand vom Mai 2023 lassen sich die Ergebnisse verbessern, wenn ChatGPT zusammen mit dem Browser-Plugin webchatgpt.app verwendet wird.

Verwandte Artikel

![]()

Matthias Fenkart ist Erwachsenenbildner 2024!

Mit einer Lehr- und Lernplattform für Gebärdensprache hat Matthias Fenkart den Staatspreis gewonnen. Im Gespräch erzählt er über digitale Chancen und Hürden für gehörlose Menschen.![Person setzt einen Würfel mit einem Bild mit Pfeil und Bogen auf einen Würfelturmmit weiteren Bildern]()

Bildungsinteressierte für ihre Kompetenzen sensibilisieren

Auf erwachsenenbildung.at finden Ratsuchende Tipps und Ideen, um sich mit eigenen Stärken und Interessen auseinanderzusetzen und passende Beratungsangebote zu finden.![]()

Erwachsenenbildner*innen zu Besuch bei der Ausstellung zu KI und Mensch

Wie man bei der Nutzung von KI Daten schützen sollte und wie KI Diskriminierung zementiert: Die Ausstellung in Wien unterstützt dabei, für einen kritischen Umgang mit KI zu sensibilisieren.![Weltkugel in zwei Händen. Die Hände tragen Arbeitshandschuhe.]()

Das Jahr 2050: Zu wenig Green Skills in einem überholten Europa?

Wissenschaftler*innen skizzieren vier mögliche Zukunftsszenarien für Europa und leiten daraus Vorschläge ab, die auch die Erwachsenenbildung betreffen.![KI-Unterstützung bei der Arbeit mit Videos]()

Video: KI-Unterstützung bei der Arbeit mit Videos

Videos zusammenfassen, mit wenigen Klicks aufbereiten oder gar erzeugen: Erwachsenenbildner*innen können KI-Tools für ganz unterschiedliche Anwendungsfälle nutzen.![]()

Neues Projekt zu Organisations- und Personalentwicklung in Bildungshäusern

Welche Kompetenzen und Werte brauchen Mitarbeitende in Bildungshäusern zukünftig? Dieser Frage widmet sich das Projekt „Future Skills“ unter der Leitung der ARGE Bildungshäuser.